面向AIGC的InfiniBand网络技术特性分析及其对数据处理与存储的支持服务

引言

随着生成式人工智能(AIGC)模型的规模、复杂度和训练数据量呈指数级增长,对底层计算、网络和存储基础设施提出了前所未有的高要求。传统的以太网在应对千卡乃至万卡级GPU集群的超大规模、低延迟、高带宽通信时逐渐显现瓶颈。InfiniBand网络技术凭借其独特的硬件卸载、极低的延迟和极高的吞吐量,已成为支撑现代AIGC训练集群的关键网络互连方案。本文旨在深入分析面向AIGC的InfiniBand网络的核心技术特性,并探讨其如何为大规模数据处理与存储提供高效支持服务。

一、 InfiniBand面向AIGC的核心技术特性分析

- 超高带宽与低延迟: AIGC训练涉及海量参数的同步(如All-Reduce操作),对网络带宽和延迟极其敏感。InfiniBand采用基于信用的流控机制、通道适配器硬件卸载以及Cut-Through交换技术,能够提供高达400Gb/s(NDR)乃至800Gb/s(XDR)的单端口带宽,端到端延迟可低至亚微秒级。这极大地加速了GPU间梯度、激活函数等数据的同步速度,缩短了模型训练时间。

- 远程直接内存访问(RDMA): 这是InfiniBand的基石特性。RDMA允许网络适配器(HCA)直接在应用程序的内存空间之间传输数据,完全绕过操作系统内核和CPU。在AIGC场景中,这意味着GPU可以直接通过RDMA读取远端存储服务器上的训练数据集,或将检查点(Checkpoint)直接写入存储,避免了昂贵的内存拷贝和CPU上下文切换,实现了“零拷贝”数据传输,极大提升了I/O效率。

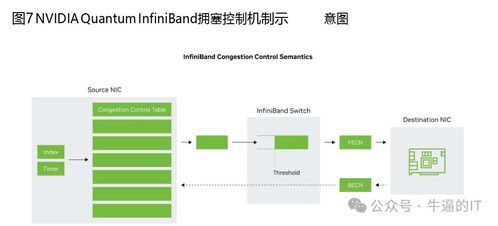

- 硬件卸载与拥塞控制: InfiniBand将通信协议(如传输层、部分应用层功能)和复杂操作(如集合通信原语)卸载到网卡硬件执行。例如,NVIDIA的SHARP技术可将All-Reduce等集合操作在交换机网络内完成聚合,大幅减少GPU间的数据流量和同步时间。其基于反馈的拥塞控制机制(如ECN)能有效管理大规模网络中的流量突发,保障关键训练流量的服务质量(QoS)。

- 可扩展性与无阻塞拓扑: 为满足万卡集群需求,InfiniBand支持构建超大规模的无阻塞(Fat-Tree, Dragonfly+等)网络拓扑。结合集中式子网管理器(SM)和自适应路由,能够实现线性扩展的性能,确保任意两个节点间的通信都具有确定的高带宽和低延迟,这是大规模分布式训练稳定性的关键。

二、 InfiniBand对AIGC数据处理与存储的支持服务

基于上述技术特性,InfiniBand网络不仅是GPU间的通信主干,也深度融入了AIGC的数据处理与存储体系,提供关键支持服务。

- 高速数据供给管道: AIGC训练需要持续从存储系统(如分布式文件系统或对象存储)向计算节点供给海量数据。通过RDMA,存储客户端可以直接从存储服务器的内存中拉取数据块,构建起一条从存储介质到GPU显存的超低延迟、高带宽直接通路。这解决了传统TCP/IP网络下数据预处理(Data Preprocessing)阶段可能成为训练瓶颈的问题。

- 并行文件系统的加速引擎: 主流的高性能并行文件系统(如Lustre, IBM Spectrum Scale, DAOS等)都深度优化了对InfiniBand RDMA的支持。它们利用RDMA实现元数据操作、数据分片的直接客户端访问,使得成千上万个计算节点可以并发、高效地读写共享的全局命名空间,完美支撑AIGC训练中检查点保存/恢复、数据集加载等密集型I/O模式。

- 存算分离架构的粘合剂: 现代AIGC基础设施常采用存算分离架构,以提升资源利用率和灵活性。InfiniBand的高性能统一网络将计算池、存储池(包括高性能全闪存阵列)紧密连接,使得存储访问的延迟和带宽接近于本地NVMe SSD,从而模糊了“分离”带来的性能鸿沟,使得计算节点可以像访问本地数据一样高效地使用远程存储服务。

- 支持多租户与数据安全: 在云上或企业级AIGC平台中,InfiniBand支持通过分区(Partition)和 QoS策略实现网络资源的逻辑隔离与保障,确保不同团队或任务的数据流互不干扰且获得承诺的带宽。从硬件层面支持如IPsec等加密卸载,为敏感训练数据在网络上传输提供安全保障。

三、 挑战与展望

尽管优势显著,InfiniBand在AIGC领域的应用也面临成本较高、技术生态相对封闭、运维复杂性等挑战。未来发展趋势包括:

- 与以太网的融合与竞争: RoCEv2(基于融合以太网的RDMA)技术正在追赶,但在超大规模集群的端到端性能和可管理性上仍与InfiniBand存在差距。两者将在不同场景下共存竞争。

- 更紧密的软硬件协同: 如NVIDIA的Quantum-2平台与CUDA、AI框架的深度集成,提供端到端的加速解决方案。

- 面向新型工作负载的优化: 针对AIGC推理、多模态训练、科学计算与AI融合等新兴负载,InfiniBand技术将持续演进,提供更智能的网络服务。

结论

面向AIGC的InfiniBand网络,以其超高性能、硬件卸载和RDMA为核心,构建了支撑万亿参数模型训练的通信与I/O基石。它不仅极大地加速了GPU间的协同计算,更通过提供高速、直接的数据访问服务,深刻变革了AIGC数据处理与存储的范式。随着AIGC技术的不断发展,InfiniBand及其演进技术将继续作为关键基础设施,驱动人工智能前沿探索的边界。

如若转载,请注明出处:http://www.xingfuqhd.com/product/30.html

更新时间:2026-02-27 00:22:23